فایل LLMs.txt چیست و چه کاری انجام میدهد؟

فایل llms.txt یه فایل متنی خاصه که به سیستمهای هوش مصنوعی و مدلهای زبان بزرگ اجازه میده وبسایتها رو بهتر درک کنن. برای بررسی دقیقتر این موضوع با ما همراه باشین!

با پیشرفت سریع فناوریهای هوش مصنوعی، مدلهای زبان بزرگ (LLM) دارن روش دسترسی کاربرها به اطلاعات رو حسابی تغییر میدن. سیستمهای مبتنی بر هوش مصنوعی مثل ChatGPT، گوگل Gemini، Claude و Perplexity با هدف پردازش محتوای پیچیدهی وب و ارائه جوابهای سریعتر، دقیقتر و مرتبطتر به کاربرها ساخته شدن. اما توی این فرآیند، به خاطر ساختارهای پیچیده HTML، کدهای غیرضروری و مسدودسازی توسط فایل robots.txt در وبسایتها، ممکنه موانعی برای هوش مصنوعی به وجود بیاد. اینجا دقیقا همون جاییه که فایل llms.txt، که این روزها خیلی سر و صدا کرده، وارد میدون میشه.

توی این راهنما، قراره به نکات مهمی مثل اینکه llms.txt چیه، چطور کار میکنه، چه فرقی با robots.txt داره، چطور باید درستش کرد و چرا باید مرتب چکش کرد، بپردازیم. پس بزن بریم ببینیم این llms.txt چیه.

فایل llms.txt یه فایل متنی خاصه که به سیستمهای هوش مصنوعی و مدلهای زبان بزرگ اجازه میده وبسایتها رو به شکل موثرتری بفهمن. این فایل که توی ریشه اصلی (root directory) وبسایت شما قرار میگیره، به سیستمهای هوش مصنوعی مثل ChatGPT، گوگل Gemini، Claude و Perplexity کمک میکنه تا محتوای سایت شما رو دقیقتر و کارآمدتر پردازش کنن.

داستان شکلگیری Llms.txt

به نظر میرسه که فرمت llms.txt در نتیجهی ناکافی بودن استانداردهای وب سنتی برای سیستمهای هوش مصنوعی به وجود اومده. این استاندارد که چندی پیش توسط جرمی هاوارد پیشنهاد شد، هدفش اینه که محتوای وب توسط سیستمهای هوش مصنوعی به شکل کارآمدتری استفاده بشه. اساس این ایده اینه که ساختار پیچیده و حجم زیاد صفحات HTML، درک محتوا رو برای سیستمهای هوش مصنوعی سخت میکنه. اینکه فایل llms.txt این روزها سر زبونها افتاده، میتونه به تلاشهای Answer.AI برای افزایش آگاهی از برندش هم ربط داشته باشه. اینکه در آینده چه اتفاقی میفته و به کدوم سمت میره، جای سوال داره. در ضمن، هنوز هیچ اطلاعاتی مبنی بر اینکه گوگل از این فایل پشتیبانی میکنه، وجود نداره.

فایل Llms.txt دقیقا چیکار میکنه؟

فایل llms.txt به مدلهای زبان بزرگ کمک میکنه تا وبسایت شما رو بهتر درک و پردازش کنن. این فایل محتوای مهم وبسایت شما رو خلاصه میکنه تا مدلهای هوش مصنوعی رو راهنمایی کنه و بهشون اجازه بده جوابهای دقیقتر و موثرتری به سوالات کاربرها بدن.

همونطور که میدونین، محتوای وب HTML هست و اغلب شامل ساختارهای پیچیده، منوهای ناوبری، تبلیغات، جاوا اسکریپت و چیزهای دیگه میشه. این موضوع باعث میشه مدلهای زبان بزرگ برای دسترسی به محتوا و درک اون با مشکل مواجه بشن. فایل llms.txt هدفش اینه که این پیچیدگی رو از بین ببره و به مدلهای هوش مصنوعی، دادههای ساده، شفاف و قابل پردازش بده.

تفاوتهای بین Llms.txt و Robots.txt چیه؟

فایلهای llms.txt و robots.txt برای بهینهسازی وبسایتها با اهداف متفاوتی به کار میرن. هر دوتاشون توی ریشه اصلی وبسایت قرار میگیرن و ساختاری قابل خوندن برای ماشین دارن. اما امروزه، هدف استفاده و مخاطب هدفشون با هم فرق داره. شاید در آینده بشه اونها رو توی فایل robots.txt ادغام کرد. بیایین تفاوتهای اصلی این دو فایل رو به صورت دستهبندی شده بررسی کنیم.

۱. هدف این فایلها

- Llms.txt:

– به مدلهای زبان بزرگ اجازه میده محتوای وبسایت شما رو بهتر بفهمن.

– مهمترین محتوای سایت شما رو در یک فرمت ساده و شفاف به سیستمهای هوش مصنوعی ارائه میده.

– هدف: بهینهسازی برای هوش مصنوعی (GEO – Generative Engine Optimization) و ارائه دانش.

- Robots.txt:

– کنترل میکنه که رباتهای موتور جستجو چطور سایت شما رو خزش (crawl) کنن.

– اجازه میده یا جلوی خزش یا ایندکس شدن صفحات یا دایرکتوریهای خاصی رو میگیره.

– هدف: آسون کردن کشف صفحات از طریق فراهم کردن یک ساختار قابل خزش در چارچوب بهینهسازی برای موتورهای جستجو (سئو).

۲. مخاطب هدف فایلها

- Llms.txt:

– سیستمهای هوش مصنوعی مبتنی بر مدلهای زبان بزرگ مثل ChatGPT، گوگل Gemini، Claude و بینگ AI رو هدف قرار میده.

- Robots.txt:

– رباتهای موتورهای جستجو مثل گوگل، بینگ و یاندکس رو هدف قرار میده.

۳. ساختار فایلها

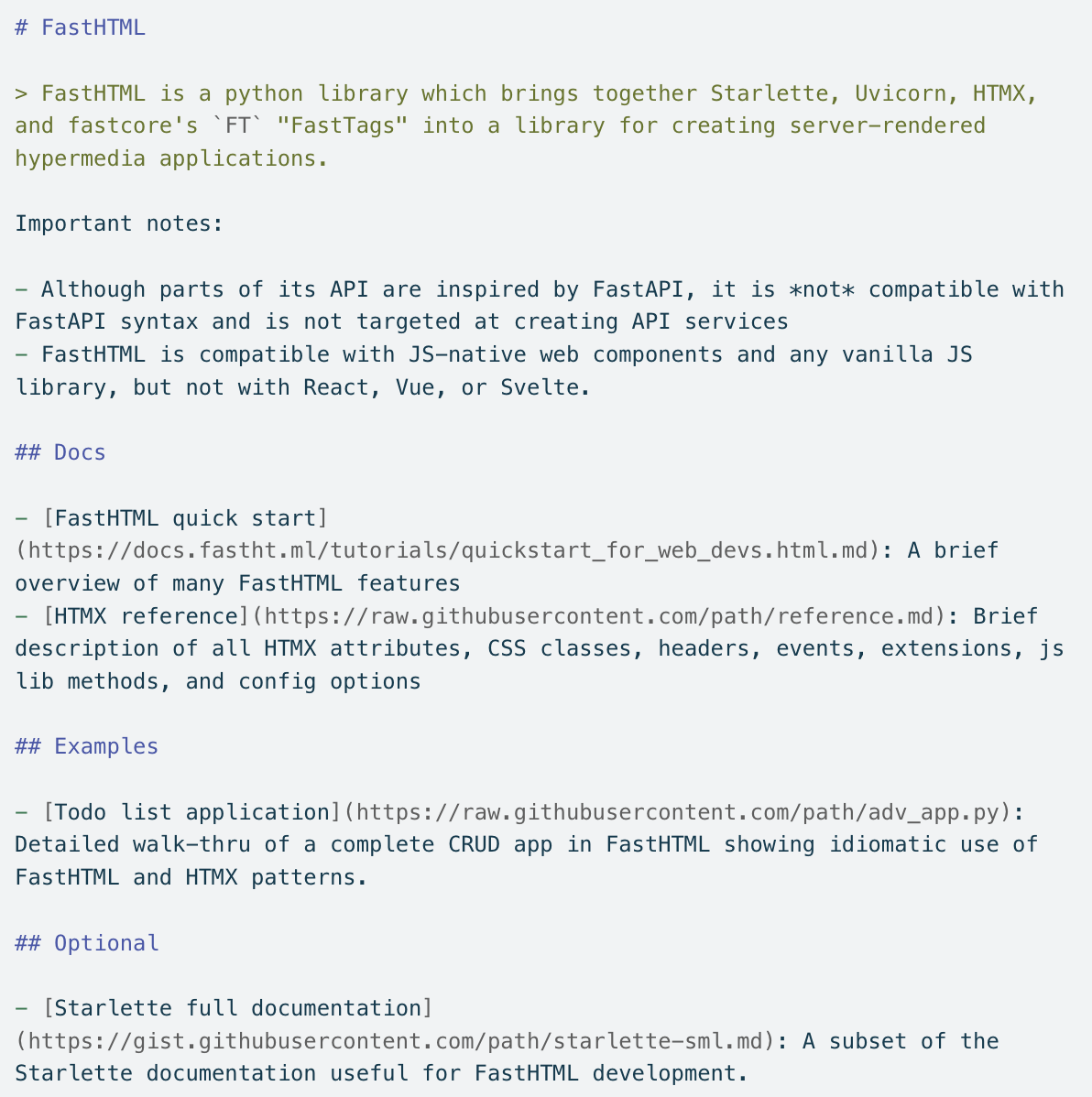

- Llms.txt:

– با فرمت Markdown آماده میشه و هم برای انسان و هم برای ماشین به راحتی قابل خوندنه.

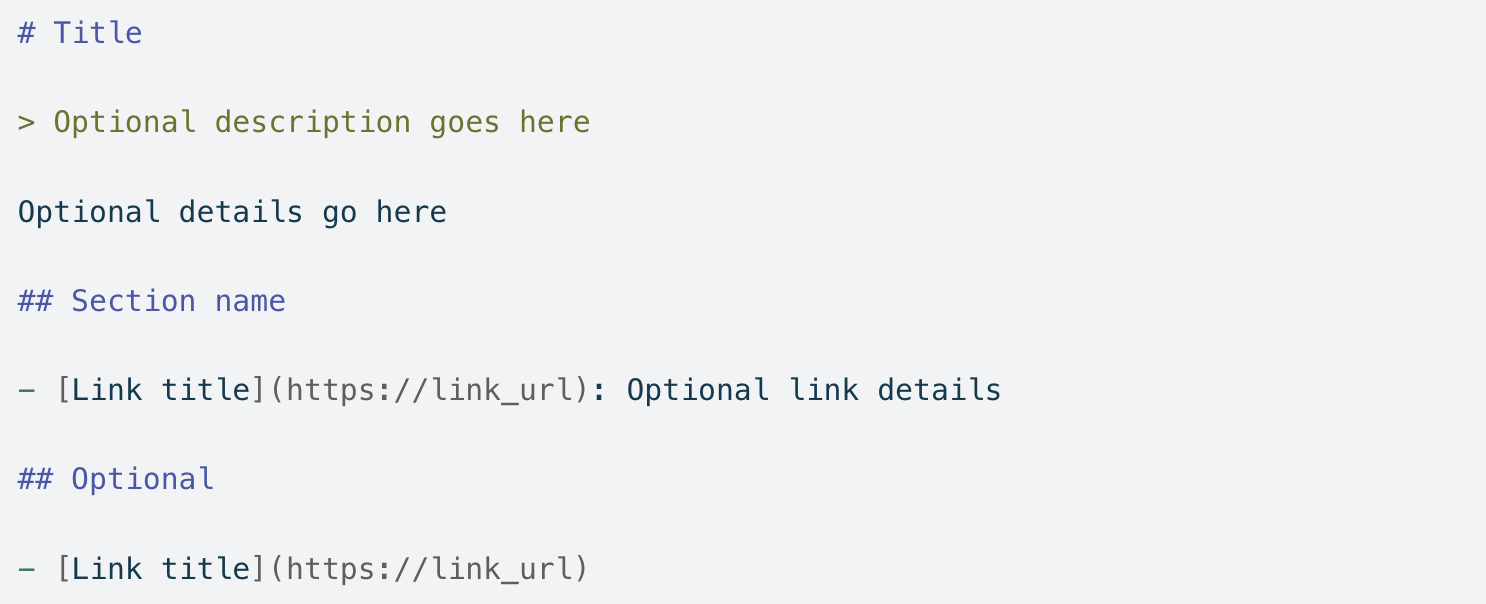

مثال:

– فرمت Markdown به هوش مصنوعی اجازه میده محتوا رو سریعتر پردازش کنه.

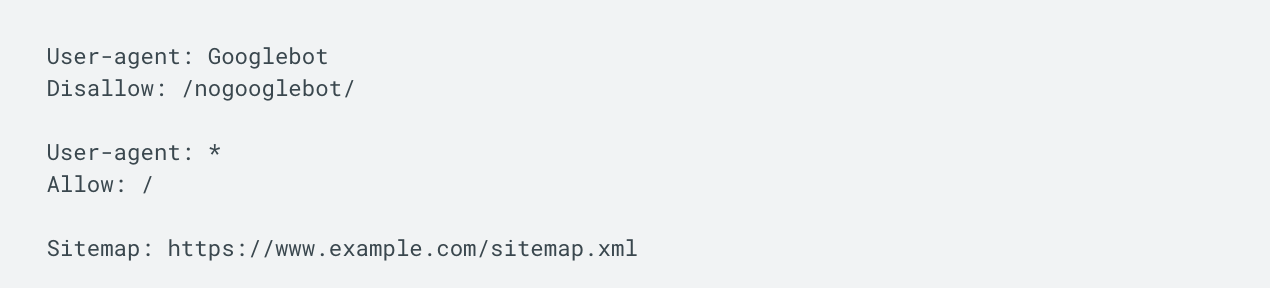

- Robots.txt:

– در یک فرمت فایل متنی ساده نوشته میشه و قوانین خزش مخصوص رباتها رو ارائه میده.

مثال:

– به رباتها میگه کدوم صفحات رو میتونن خزش کنن یا کدومها مسدود شدن.

۴. ارتباط این فایلها با سئو

- Llms.txt:

– با فراهم کردن بهینهسازی برای هوش مصنوعی (GEO)، به سیستمهای مبتنی بر LLM امکان میده تا برای افزایش دیده شدن، سایت شما رو کشف کنن.

- Robots.txt:

– بخشی از سئو هست، اما با کنترل نحوه خزش سایت شما توسط موتورهای جستجو، اونها رو راهنمایی میکنه.

نکاتی که باید موقع ساخت فایل llms.txt در نظر بگیرین

نکاتی که موقع ساخت فایل llms.txt باید بهشون توجه کرد، برای اینکه فایل به درستی و به طور موثر توسط سیستمهای هوش مصنوعی پردازش بشه، خیلی مهمن. به خصوص، نوشتن فایل با فرمت Markdown و اطمینان از اینکه محتوا واضح، منظم و قابل فهمه، به مدلهای زبان بزرگ اجازه میده این فایل رو به راحتی درک کنن. بیایین نگاهی به عناصر اساسی که باید موقع ساخت فایل llms.txt در نظر گرفت، بندازیم.

- با استفاده از فرمت Markdown یک فایل ساده و قابل فهم بسازین.

- فقط محتوای مهم رو قرار بدین و از جزئیات غیرضروری دوری کنین.

- از ساختارهای پیچیده مثل HTML یا جاوا اسکریپت استفاده نکنین.

- اطلاعات بهروز، دقیق و توصیفی رو وارد کنین.

- محتوای اختیاری و ثانویه رو توی یک بخش جداگونه ارائه بدین.

- مراقب باشین اطلاعات متناقضی با فایل robots.txt ارائه ندین.

- همزمان با آپدیت شدن وبسایتتون، فایل llms.txt رو هم بهروزرسانی کنین.

از خوندن خسته شدین؟

میتونین این پست وبلاگ رو به صورت پادکستی که با Google NotebookLM در اسپاتیفای ساختیم هم گوش بدین.

محتویات فایل Llms.txt

محتوای فایل llms.txt با هدف ارائه مهمترین اطلاعات، صفحات و اسناد وبسایت شما به شکلی واضح و منظم به مدلهای زبان بزرگ طراحی شده. آمادهسازی درست و موثر محتوا، فهم سایت شما رو برای هوش مصنوعی آسونتر میکنه و کمک میکنه تا جوابهای دقیقتری به سوالات کاربرها بده. محتوای فایل llms.txt باید شامل بخشهای زیر باشه:

- تگ H1: اسم پروژه یا سایت باید حتما باشه.

- بخش خلاصه (Excerpt): شامل خلاصهای از پروژه و اطلاعات کلیدی.

- اطلاعات دقیق: پاراگرافها یا لیستهایی با اطلاعات بیشتر درباره پروژه.

- لیست لینکها: URLهای مربوط به اسناد یا منابع مرتبط ارائه میشن. هر لینک میتونه به صورت اختیاری یک توضیح کوتاه هم داشته باشه.

در ضمن، باید بگیم که شما میتونین با استفاده از دستورالعملها (directive)، اطلاعات بیشتری هم اضافه کنین.

چطور فایل Llms.txt رو روی سایت پیادهسازی کنیم؟

فرآیند پیادهسازی فایل llms.txt روی وبسایت شما شامل آمادهسازی فایل با فرمت درست، آپلود اون در دایرکتوری صحیح و تست کردن قابلیت دسترسیش میشه. میتونین مراحل زیر رو برای پیادهسازی موفق فایل llms.txt دنبال کنین.

- فایل llms.txt رو با فرمت Markdown آماده کنین.

- فایل رو توی ریشه اصلی (root directory) وبسایتتون آپلود کنین.

- یک ارجاع به اون رو توی فایل robots.txt اضافه کنین.

- قابلیت دسترسی به فایل رو توی مرورگر چک کنین.

- مجوزهای لازم رو برای رباتهای هوش مصنوعی تعریف کنین تا فایل رو پیدا کنن.

- فایل llms.txt رو مرتباً آپدیت کنین و با ابزارهای اعتبارسنجی تستش کنین.

چطور فایل Llms.txt رو در وردپرس بسازیم؟

اگه صاحب یک سایت وردپرسی هستین، میتونین فایل llms.txt رو به صورت دستی با اضافه کردنش به پوشه public_html استفاده کنین. اگه نمیتونین این کار رو انجام بدین، میتونین با کمک افزونهها هم در وردپرس فایل llms.txt رو بسازین.

چرا پیگیری درخواستهای ورودی بعد از راهاندازی llms.txt مهمه؟

بعد از اینکه فایل llms.txt رو روی وبسایتتون پیادهسازی کردین، نظارت بر درخواستهایی که از طرف سیستمهای مبتنی بر هوش مصنوعی میان، برای ارزیابی تاثیر فایل و فهمیدن اینکه آیا درست کار میکنه یا نه، خیلی حیاتیه. این فرآیند فراتر از صرفاً چک کردن وجود فایل هست. این کار به شما اجازه میده بفهمین اطلاعاتی که از طریق فایل ارائه شده چطور استفاده میشه، کدوم رباتهای هوش مصنوعی بهش دسترسی دارن و ترافیک سایت شما چطور تحت تاثیر قرار گرفته.

پاسخی بگذارید