ایندکس شدن و سئو: ۹ گام تا پیدا شدن محتوای شما توسط گوگل و بینگ

ایندکس نشدن = دیده نشدن. با این چندتا قدم ساده، کاری کن محتوات ایندکس بشه و حضورت رو توی نتایج جستجو پررنگتر کن.

از دیدن خطای «Discovered – currently not indexed» توی سرچ کنسول گوگل (GSC) کلافه شدی؟

منم همینطور.

خیلی از تلاشهای سئو فقط روی رتبه گرفتن متمرکز شده.

اما خیلی از سایتها اگه یه پله بالاتر رو نگاه کنن و به ایندکس شدن توجه کنن، سود خیلی بیشتری میبرن.

چرا؟

چون تا وقتی محتوای شما ایندکس نشده باشه، اصلاً وارد رقابت نمیشه.

فرقی نمیکنه سیستم انتخاب محتوا، رتبهبندی باشه یا تولید محتوای افزوده با بازیابی (RAG)، تا وقتی محتوای شما ایندکس نشده باشه، هیچ اهمیتی نداره.

این موضوع برای هر جایی که قراره محتواتون نمایش داده بشه صدق میکنه؛ چه نتایج جستجوی سنتی (SERP)، چه نتایج تولید شده با هوش مصنوعی، بخش Discover، Shopping، News، Gemini، ChatGPT یا هر ابزار هوش مصنوعی دیگهای که در آینده میاد.

بدون ایندکس شدن، نه دیده میشی، نه کلیکی در کاره و نه تأثیری میذاری.

و متأسفانه، مشکلات مربوط به ایندکس شدن خیلی شایع هستن.

بر اساس تجربهی من در کار با صدها سایت بزرگ، به طور متوسط ۹ درصد از صفحات محتوای عمیق و باارزش (مثل محصولات، مقالات، لیستها و غیره) توسط گوگل و بینگ ایندکس نمیشن.

خب، چطور مطمئن بشیم که محتوای عمیق سایتمون ایندکس میشه؟

این ۹ قدم اثباتشده رو دنبال کن تا این فرایند رو سریعتر کنی و دیده شدن سایتت رو به حداکثر برسونی.

قدم اول: محتوای خودت رو برای پیدا کردن مشکلات ایندکس بررسی کن

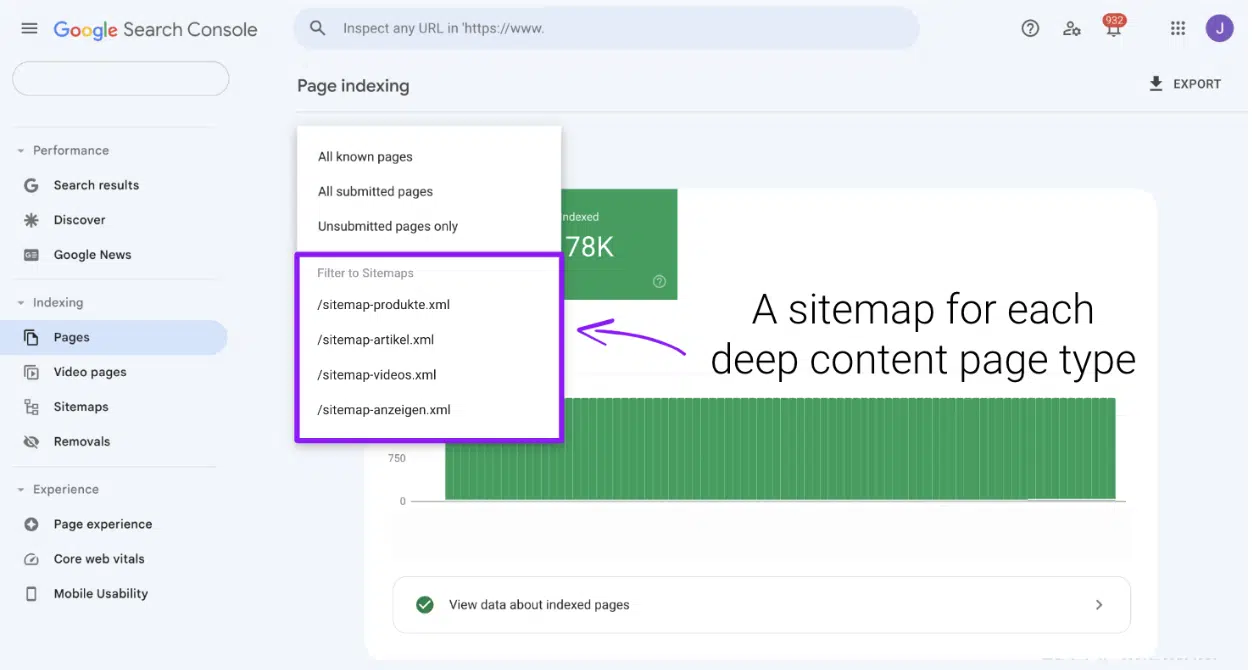

توی سرچ کنسول گوگل و بینگ وبمستر تولز، برای هر نوع صفحه یک سایتمپ جداگانه ثبت کن:

- یکی برای محصولات.

- یکی برای مقالهها.

- یکی برای ویدیوها.

- و به همین ترتیب برای بقیه موارد.

بعد از ثبت سایتمپ، ممکنه چند روز طول بکشه تا اطلاعاتش توی بخش Pages نمایش داده بشه.

از این بخش استفاده کن تا ببینی چه مقدار از محتوای شما از ایندکس شدن محروم شده و مهمتر از اون، دلایل دقیق این اتفاق چی بوده.

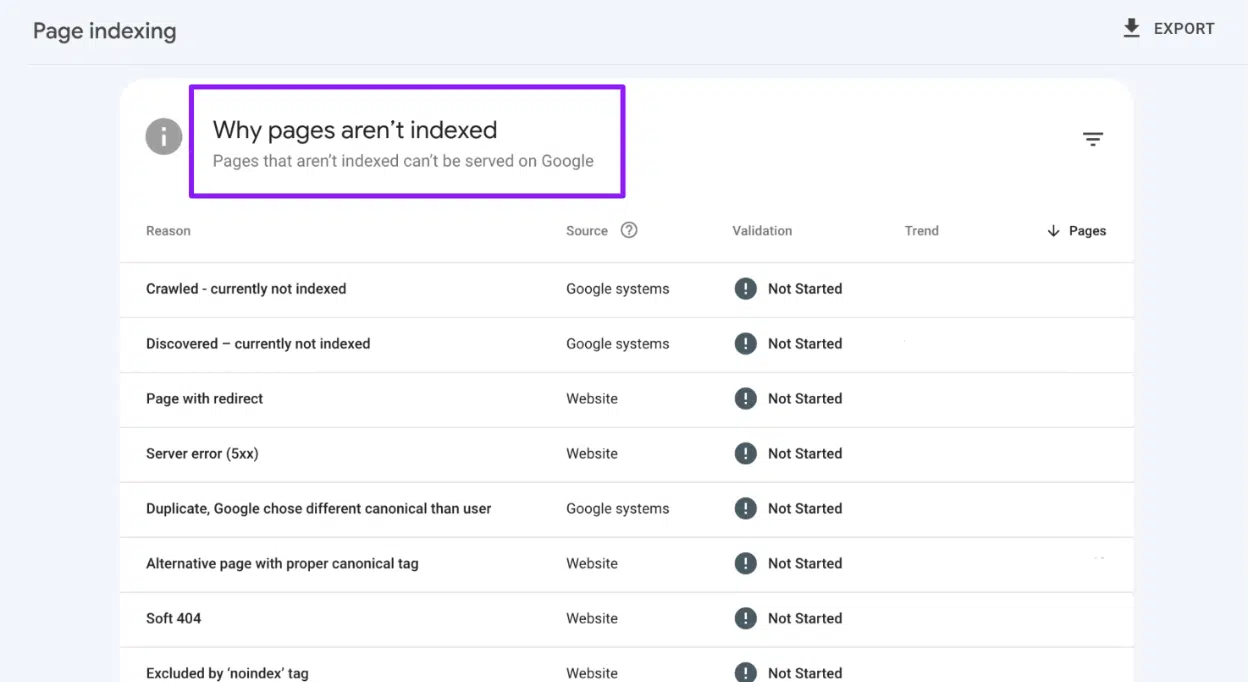

تمام مشکلات ایندکس شدن در سه دستهی اصلی قرار میگیرن:

- دستورالعملهای سئوی ضعیف

- این مشکلات از اشتباهات فنی ناشی میشن، مثل:

- صفحاتی که با robots.txt مسدود شدن.

- تگهای کنونیکال اشتباه.

- دستورالعملهای noindex.

- خطاهای ۴۰۴.

- یا ریدایرکتهای ۳۰۱.

- راه حلش سادهست: این صفحات رو از سایتمپ خودت حذف کن.

- این مشکلات از اشتباهات فنی ناشی میشن، مثل:

- کیفیت پایین محتوا

- اگه صفحات ثبتشده خطای soft 404 یا مشکلات کیفی محتوا رو نشون میدن، اول مطمئن شو که تمام محتوای مرتبط با سئو به صورت سرور-ساید (server-side) رندر میشه.

- بعد از اینکه مطمئن شدی، روی بهبود ارزش محتوا تمرکز کن؛ یعنی عمق، ارتباط و یکتا بودن صفحه رو افزایش بده.

- مشکلات پردازشی

- اینها پیچیدهتر هستن و معمولاً منجر به خطاهایی مثل «Discovered – currently not indexed» یا «Crawled – currently not indexed» میشن.

با اینکه دو دستهی اول رو میشه نسبتاً سریع حل کرد، اما مشکلات پردازشی به زمان و توجه بیشتری نیاز دارن.

با استفاده از دادههای ایندکس سایتمپ به عنوان معیار، میتونی پیشرفت خودت رو در بهبود عملکرد ایندکس سایتت دنبال کنی.

قدم دوم: برای ایندکس سریعتر مقالات، یک سایتمپ خبری ثبت کن

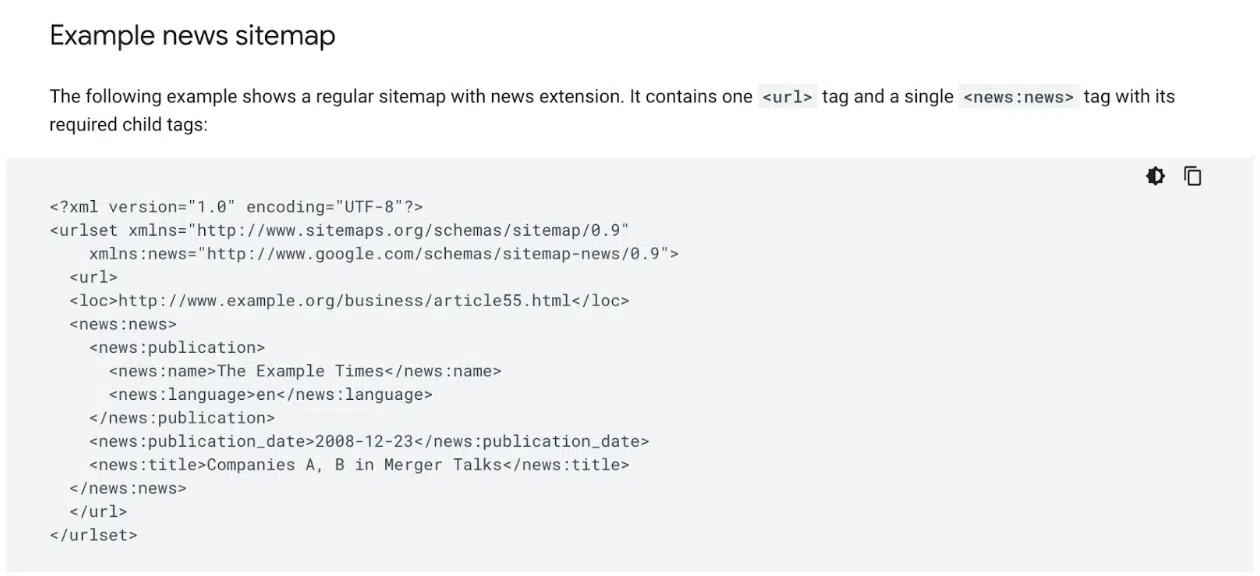

برای ایندکس شدن مقالات در گوگل، حتماً یک سایتمپ خبری (News sitemap) ثبت کن.

این سایتمپ تخصصی، تگهای خاصی داره که برای سرعت بخشیدن به ایندکس مقالاتی که در ۴۸ ساعت گذشته منتشر شدن، طراحی شده.

نکته مهم اینه که برای بهرهمندی از این روش، لازم نیست محتوای شما حتماً ماهیت «خبری» سنتی داشته باشه.

قدم سوم: از فیدهای گوگل مرچنت سنتر برای بهبود ایندکس محصولات استفاده کن

با اینکه این روش فقط برای گوگل و دستهبندیهای خاصی کاربرد داره، اما ثبت محصولات در گوگل مرچنت سنتر میتونه به طور قابل توجهی ایندکس شدن رو بهبود بده.

مطمئن شو که کل کاتالوگ محصولات فعال شما اضافه شده و همیشه بهروز نگه داشته میشه.

قدم چهارم: از فید RSS برای اطلاعرسانی سریعتر استفاده کن

یک فید RSS بساز که شامل محتوای منتشر شده در ۴۸ ساعت گذشته باشه.

این فید رو در بخش Sitemaps در سرچ کنسول گوگل و بینگ وبمستر تولز ثبت کن.

این روش خیلی خوب جواب میده چون فیدهای RSS ذاتاً بیشتر از سایتمپهای XML سنتی کراول میشن.

به علاوه، ایندکسرها هنوز به پینگهای WebSub برای فیدهای RSS پاسخ میدن؛ پروتکلی که دیگه برای سایتمپهای XML پشتیبانی نمیشه.

برای اینکه بیشترین بهره رو ببری، مطمئن شو که تیم فنی شما WebSub رو هم پیادهسازی کرده.

قدم پنجم: از APIهای ایندکسینگ برای کشف سریعتر محتوا استفاده کن

هم IndexNow (که نامحدوده) و هم Google Indexing API (که به ۲۰۰ فراخوانی در روز محدوده، مگه اینکه بتونی سهمیه بیشتری بگیری) رو با سایتت یکپارچه کن.

به طور رسمی، Google Indexing API فقط برای صفحاتیه که دارای نشانهگذاری آگهی استخدام یا رویدادهای زنده هستن.

(نکته: کلمهی کلیدی اینجا «به طور رسمی» هست. تصمیم با خودته که بخوای اون رو برای موارد دیگه هم تست کنی یا نه.)

قدم ششم: لینکسازی داخلی رو تقویت کن تا سیگنالهای ایندکس رو قویتر کنی

راه اصلی کشف محتوا برای اکثر ایندکسرها، از طریق لینکهاست.

URLهایی که سیگنالهای لینک قویتری دارن، در صف کراول در اولویت بالاتری قرار میگیرن و قدرت ایندکس بیشتری دارن.

با اینکه لینکهای خارجی ارزشمند هستن، اما لینکسازی داخلی برای ایندکس کردن سایتهای بزرگ با هزاران صفحه محتوای عمیق، یه برگ برنده واقعیه.

بخشهای محتوای مرتبط، صفحهبندی (pagination)، مسیر راهنما (breadcrumbs) و به خصوص لینکهایی که در صفحه اصلی شما نمایش داده میشن، نقاط اصلی بهینهسازی برای رباتهای گوگل و بینگ هستن.

وقتی صحبت از صفحه اصلی میشه، نمیتونی به همهی صفحات عمیق لینک بدی، اما نیازی هم به این کار نیست.

روی اونهایی تمرکز کن که هنوز ایندکس نشدن. اینطوری:

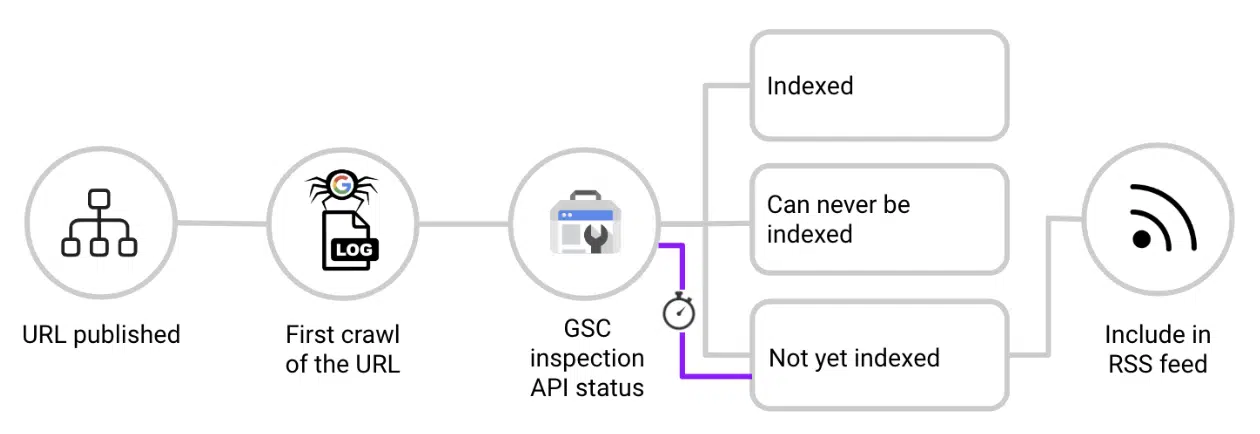

- وقتی یک URL جدید منتشر میشه، اون رو با فایلهای لاگ سرور چک کن.

- به محض اینکه دیدی ربات گوگل برای اولین بار URL رو کراول کرد، یک درخواست به API بازرسی سرچ کنسول گوگل بفرست.

- اگه پاسخ «URL is unknown to Google»، «Crawled, not indexed» یا «Discovered, not indexed» بود، اون URL رو به یک فید اختصاصی اضافه کن که محتوای یک بخش از صفحه اصلی شما رو تأمین میکنه.

- به صورت دورهای URL رو دوباره بررسی کن. وقتی ایندکس شد، اون رو از فید صفحه اصلی حذف کن تا این بخش همیشه مرتبط باقی بمونه و روی محتوای ایندکس نشدهی دیگه تمرکز کنه.

این کار عملاً یک فید RSS زنده از محتوای ایندکسنشده ایجاد میکنه که از صفحه اصلی به اونها لینک داده شده و از اعتبار صفحه اصلی برای سرعت بخشیدن به ایندکس شدن استفاده میکنه.

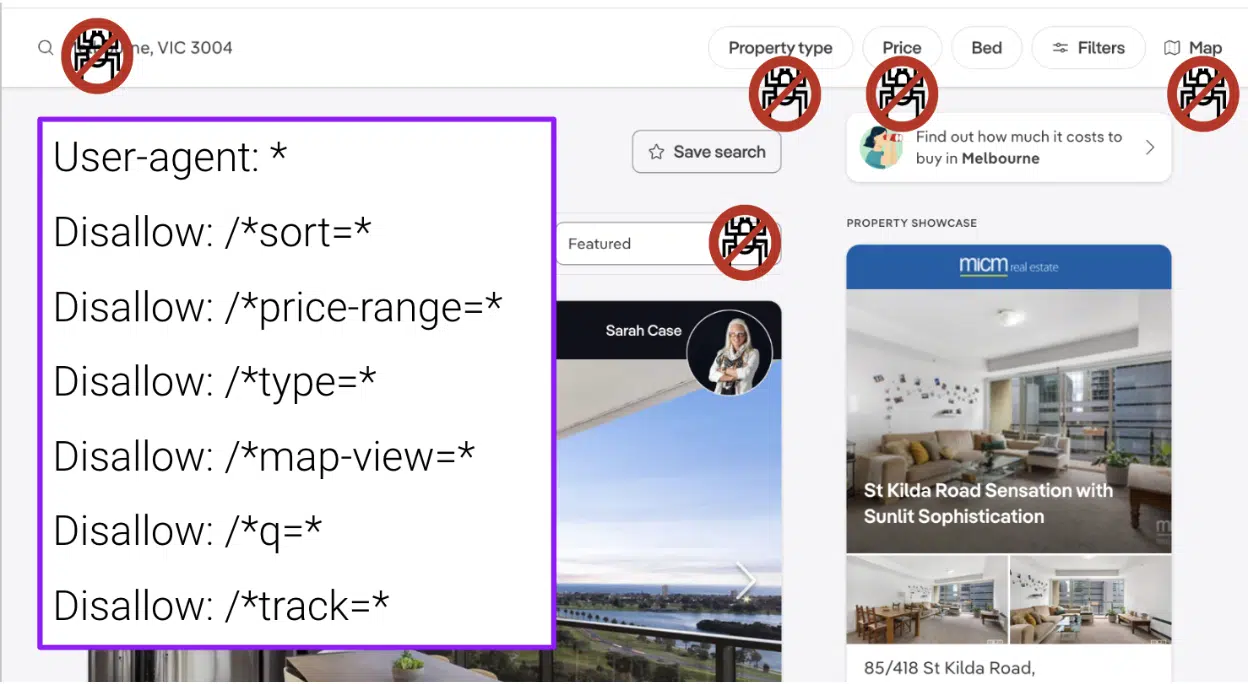

قدم هفتم: دسترسی رباتها به URLهای نامرتبط با سئو رو مسدود کن

فایلهای لاگ سرور رو به طور منظم بررسی کن و مسیرهای URLی که زیاد کراول میشن اما ارزشی ندارن رو با دستور disallow در فایل robots.txt مسدود کن.

صفحاتی مثل فیلترهای جستجو (faceted navigation)، صفحات نتایج جستجوی داخلی، پارامترهای ردیابی و محتوای نامرتبط دیگه میتونن:

- حواس رباتهای خزنده رو پرت کنن.

- محتوای تکراری ایجاد کنن.

- سیگنالهای رتبهبندی رو تقسیم کنن.

- و در نهایت، دیدگاه ایندکسرها نسبت به کیفیت سایت شما رو پایین بیارن.

اما، استفاده از disallow در robots.txt به تنهایی کافی نیست.

اگه این صفحات لینک داخلی، ترافیک یا سیگنالهای رتبهبندی دیگهای داشته باشن، ایندکسرها ممکنه باز هم اونها رو ایندکس کنن.

برای جلوگیری از این اتفاق:

- علاوه بر مسدود کردن مسیر در robots.txt، به تمام لینکهای احتمالی که به این صفحات اشاره دارن، تگ rel=”nofollow” رو اضافه کن.

- مطمئن شو که این کار نه تنها در سایت، بلکه در ایمیلهای تراکنشی و سایر کانالهای ارتباطی هم انجام میشه تا ایندکسرها هرگز این URLها رو کشف نکنن.

قدم هشتم: از پاسخهای 304 برای کمک به اولویتبندی محتوای جدید توسط رباتها استفاده کن

برای اکثر سایتها، بخش عمدهای از فرایند کراول صرف بهروزرسانی محتوای از قبل ایندکس شده میشه.

وقتی یک سایت کد پاسخ ۲۰۰ رو برمیگردونه، ایندکسرها محتوا رو دوباره دانلود میکنن و اون رو با نسخهی ذخیرهشده در حافظهی پنهان خودشون مقایسه میکنن.

با اینکه این کار وقتی محتوا تغییر کرده ارزشمنده، اما برای اکثر صفحات ضروری نیست.

برای محتوایی که بهروز نشده، کد پاسخ HTTP ۳۰۴ (یعنی «Not Modified» یا «تغییر نکرده») رو برگردون.

این کار به رباتها میگه که صفحه تغییری نکرده و به ایندکسرها اجازه میده منابعشون رو به جای این کار، صرف کشف محتوای جدید کنن.

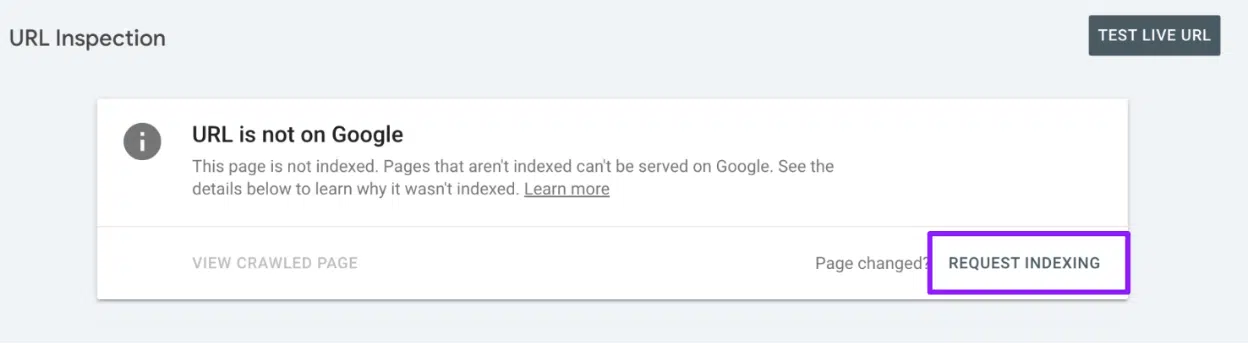

قدم نهم: برای صفحات سمج، دستی درخواست ایندکس بده

برای اون URLهای سرسختی که ایندکس نمیشن، به صورت دستی در سرچ کنسول گوگل درخواست ایندکس بده.

البته یادت باشه که روزانه فقط ۱۰ بار میتونی این کار رو انجام بدی، پس هوشمندانه ازش استفاده کن.

بر اساس تستهای من، ثبت دستی در بینگ وبمستر تولز مزیت خاصی نسبت به ثبت از طریق IndexNow API نداره.

بنابراین، استفاده از API کارآمدتره.

حضور سایتت رو در گوگل و بینگ به حداکثر برسون

اگه محتوای شما ایندکس نشه، انگار که اصلاً وجود نداره. نذار صفحات باارزشت در برزخ باقی بمونن.

قدمهایی که به نوع محتوای شما مرتبطه رو در اولویت قرار بده، یک رویکرد فعالانه برای ایندکس شدن در پیش بگیر و پتانسیل کامل محتوات رو آزاد کن.

پاسخی بگذارید